拙著『グラフニューラルネットワーク』が重版して第 3 刷となりました。皆さまありがとうございます!

拡散モデルと最適輸送でもやりましたが、漫画家さんやイラストレーターさんが重版したときに重版感謝の描き下ろしイラストを投稿しているのを見ていいなと思ったので、僕も専門書が重版したときに重版感謝の書き下ろし専門記事を投稿します。

本稿では、ICLR 2024(5/7 - 5/11 @ウィーン)で発表されたグラフニューラルネットワーク (GNN) 関連の研究動向を紹介します。

ICLR 2024 で発表された GNN 関連の論文は全部で 170 本です。凄まじい量ですね。ICLR 2024 では全て合わせて 2296 本の論文が採択されたので、7.4 パーセントが GNN 関連ということになります。この分量からも、GNN が活気ある研究対象であることが伺えます。

以下では、代表的なトピックについて一つずつ見ていきます。

凡例:件数は Publications in ICLR 2024 を参考にしています。分類が完璧ではないケースもしばしば見られたので、あくまで参考程度にお考えください。各章の最後には参考文献一覧を載せていますが、それは本稿で触れた文献であり、○件の論文をすべて列挙しているわけではありません。完全なリストを見たい方は Publications in ICLR 2024 を参照してください。

解釈性(14 件)

他の深層学習手法と同様、GNN でも解釈や信頼性の重要性が叫ばれています。GNNExplainer [Ying+ NeurIPS 2019] の登場あたりから、かれこれ 5 年くらいずっとホットなトピックです。GNN はベクトル用のニューラルネットワークよりも一般的なので、GNN の解釈はベクトル用のニューラルネットワークの解釈よりも一段難しい問題です。そのため、スッキリとした解決はまだ遠く、いろんなアプローチの模索が続いている段階のように思います。

ICLR 2024 でのこのトピックのおすすめは [Kosan+ ICLR 2024] です。この論文では、さまざまな GNN の解釈性手法の特性や性能をベンチマークしています。この論文での結論はそれなりに良い解釈手法もあるが、安定性などまだまだ課題はある、というものです。この論文では反実仮想説明を詳しく取り扱っています。反実仮想説明とは、入力例をどのように変化させたら別の予測がされるかを基に解釈を行うというアプローチであり、GNN に限らず一般の機械学習モデルの解釈方法として人気です。ローンの審査において、あなたは落ちてしまったけど、年収があと 100 万円高ければ、ウチのモデルは合格と判断していました、というような説明です。GNN においても、この化合物は毒があると判断されてしまったけど、この官能基が付いていれば毒がないと予測していました、というような反実仮想説明が用いられます。そういった説明を生成する手法はいくつかあるのですが、現実的ではない仮想データを生成してしまうことがこの論文で指摘されています。非連結なグラフを生成してしまったり、炭素原子に 10 個の水素原子が結合していたりして、化合物としての体裁を保っていないような仮想データが生成されてしまうことがしばしばあります。もしも〇〇だったらなぁの〇〇が突飛すぎて現実的な解釈としては役に立たないというわけです。このような問題意識はこの論文以前からあり、生成モデルを用いて尤もらしいグラフだけを使う [Fang+ NeurIPS 2023, Ma+ NeurIPS 2022] といったことも提案されていますが、それでもおかしなグラフを生成してしまうことはあります。生成モデルも完璧ではないので、生成モデルの上で説明を探索すると、生成モデルがうまく訓練されていない領域に到達して、生成モデルが尤もらしいと勘違いしているが実はそうではないデータが生成されてしまったりするわけです。生成モデルも日進月歩なので、生成モデル自体が成長することでこのアプローチも自動的に改善すると考えられ、そのような生成モデルと取り入れることが一つの将来の方向性だとこの論文では指摘しています。この他、連結性や化合物の価数制約などは、説明手法の側でハードに制約を設けながら説明を探索するアプローチも考えられます。この論文は GNN 解釈性のサーベイ論文的な側面があり、これまでの研究の流れから最新の動向まで分かるので、このトピックに入門したい人におすすめです。

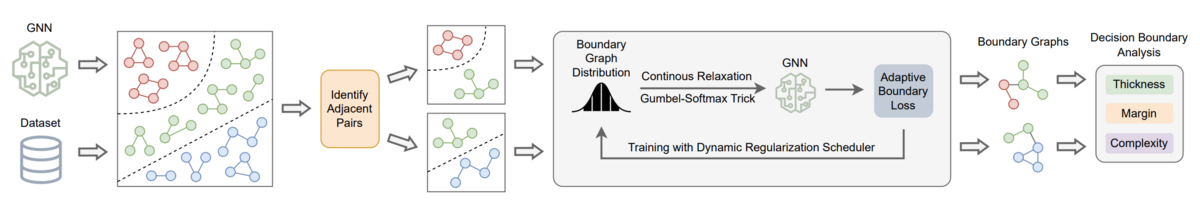

この他、解釈性についていろんなアプローチの手法が ICLR 2024 では提案されました。Wang ら [Wang+ ICLR 2024] は決定境界にあるギリギリのグラフを構築することで、モデルの分類法則を解釈する方法 GNNBoundary を提案しています(上図)。Müller ら [Müller+ ICLR 2024] はメッセージ伝達を決定木に蒸留することでモデルの分類法則を解釈する方法 GraphChef を提案しています。

これを使っておけば間違いないというような手法は少なくとも今のところは無いので、タスクの性質やどういう説明が欲しいかといった個々の状況に応じて適切な手法を選択する力量が求められています。

- [Ying+ NeurIPS 2019] GNNExplainer: Generating Explanations for Graph Neural Networks.

- [Kosan+ ICLR 2024] GNNX-BENCH: Unravelling the Utility of Perturbation-based GNN Explainers through In-depth Benchmarking.

- [Fang+ NeurIPS 2023] Evaluating Post-hoc Explanations for Graph Neural Networks via Robustness Analysis.

- [Ma+ NeurIPS 2022] CLEAR: Generative Counterfactual Explanations on Graphs.

- [Wang+ ICLR 2024] GNNBoundary: Towards Explaining Graph Neural Networks through the Lens of Decision Boundaries.

- [Müller+ ICLR 2024] GraphChef: Decision-Tree Recipes to Explain Graph Neural Networks.

同変性(14 件)

モデルが同変 (equivariant) であるとは、ざっくり言うと、モデルが入力データの対称性を保存して出力を決定するということです。例えばベンゼン(6 個の炭素が輪っかになった化合物)は対称です。ベンゼン中の一つの炭素原子は正例、他の 5 つの炭素原子は負例と分類するモデルは対称性を破っているので同変ではありません。同変なモデルでは全部を正例とするか、全部を負例とするかのどちらかであることが保証されます。タスクによっては、入出力が同変であることが要請される場合もあり、そのようなときには同変なモデルを使うことで明らかな間違いを防げます。また、1 個の炭素原子にだけ訓練ラベルを付けた場合にも、実質他の 5 つの炭素原子にも訓練ラベルを付けたことと同じ効果が得られ、データ効率が向上します。ベンゼンの場合は明らかですが、もっと複雑な場合には人手でケアしきれないので、モデルが同変であると保証されていることは有益です。GNN は同変であることが保証されています。

同変性についての研究は大きく分けると、同変性が保証されるモデルを提案したりどういう場合に同変性が成立するかを数学的に証明する研究と、同変性をうまく活用した応用を提案する研究に分かれます。前者は関数解析などのニューラルネットワーク解析の基本的な道具のほか、群論など対称性を扱う数学的な道具が活躍するので、数学寄りの人に人気の研究分野です。ICLR 2024 では、回転や平行移動などの操作について同変である高速なモデルを提案した [Bekkers+ ICLR 2024] が一例です。

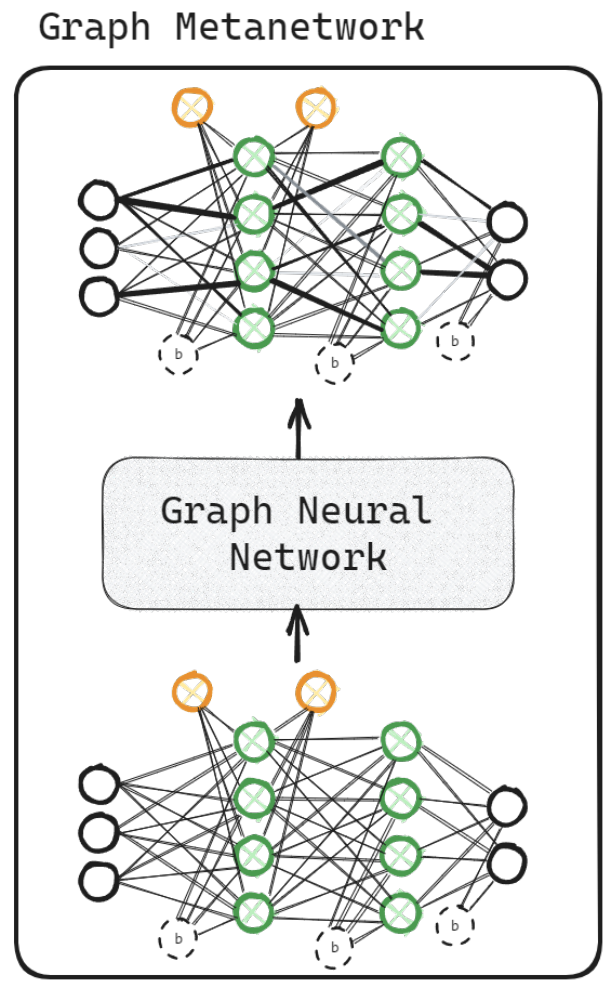

応用研究で印象的だったのは、モデルパラメータを入力として受け取るメタネットワークの 2 つの研究 [Kofinas+ ICLR 2024, Lim+ ICLR 2024] です(上図)。これらは、何百万次元からなるモデルパラメータベクトル を受け取り、そのモデルの性質を予測するモデルを得ることを目指します。入力モデルの精度を予測することが一例です。モデル自体が別のモデルに入力される一段メタな問題であることに注意してください。多層パーセプトロンなど、多くのアーキテクチャには対称性が存在します(下図)。モデルパラメータの○次元目と△次元目を入れ替えても同じモデルを表すため、それらは同じ予測をするべき、つまり次元の入れ替えについて同変(不変)であるべきです。この対称性についてはモデルパラメータの算術 - ジョイジョイジョイの記事でも紹介しました。[Kofinas+ ICLR 2024, Lim+ ICLR 2024] ではモデルパラメータベクトルを入力として受け取るタスクを GNN で解くことを提案しています。GNN は同変であるのでこのような対称性に自動で対処できます。実験では、モデルパラメータベクトルを見るだけでそのモデルの性能をかなりの精度(順位相関係数 >= 0.9)で当てられています。

- [Bekkers+ ICLR 2024] Fast, Expressive SE(n)-Equivariant Networks through Weight-Sharing in Position-Orientation Space.

- [Kofinas+ ICLR 2024] Graph Neural Networks for Learning Equivariant Representations of Neural Networks.

- [Lim+ ICLR 2024] Graph Metanetworks for Processing Diverse Neural Architectures.

- [Chijiwa ICLR 2024] Transferring Learning Trajectories of Neural Networks.

表現能力(13 件)

モデルが解ける問題の範囲をそのモデルの表現能力といいます。GNN の表現能力は複雑で、どのような問題が解けるかを調べたり、解けないとされている問題をどのようにすれば解けるようになるかを考えたりということが精力的に研究されています。このトピックも [Morris+ AAAI 2019, Xu+ ICLR 2019] から 5 年以上ホットなトピックであり続けています。このトピックは関連する問題がグラフ理論やグラフアルゴリズムで分野で古くから研究されており、それらの道具を GNN に持ってきて解析するという流れが定番です。私の以前の研究 [Sato+ NeurIPS 2019] も局所分散アルゴリズムという古典的な道具を GNN に持ってきて解析に用いるというものでした。最近は掘り出し物の飛び道具も尽きたので、細かな話題を拾いながら漸進しつつ、さてどうするかというような空気なように思います。

ICLR 2024 では部分グラフの認識可能性に基づいた研究が目立ちました。[Zhang+ ICLR 2024] では、どういう部分グラフを見分けられるかということを基準に GNN の表現能力を分類することを提案しています。今まではワイスファイラー・リーマン検査 (WL 検査) というものを基に表現能力を分類することが一般的でした。WL 検査は GNN と相性が良く、解析しやすいのですが、おおざっぱな分類しかできないことと、WL 検査を基準に〇〇ですと言われても応用者にはピンと来ないという問題がありました。どういう部分グラフを見分けられるか、であれば応用者も解釈しやすく、粒度も細かく分類できるので良い方向性だと思います。こういう考え方自体は [Chen+ NeurIPS 2020] など以前からあったのですが、[Zhang+ ICLR 2024] はこの考え方を体系化しました。[Kanatsoulis+ ICLR 2024] や [Lanzinger+ ICLR 2024] は、ではどうすれば GNN でより多くの部分グラフを見分けられるようになるかということを考えています。

もう一つ面白かったのは、[Dong+ ICLR 2024] です。グラフを見分ける問題は古くから研究されており、具体的なアルゴリズムやツールも多く開発されています。[Dong+ ICLR 2024] では、それらのツールを前処理として使って、結果を GNN に提示することで GNN の表現能力を高めることを提案しています。全てをニューラルネットワークに任せたい流派と、外部の資源を活用しながら能力を高める流派はこの分野に限らず常に綱引きの状態ですが、[Dong+ ICLR 2024] は表現能力では前者が主流だったことに対する反動の一例とも捉えられます。

- [Morris+ AAAI 2019] Weisfeiler and Leman Go Neural: Higher-order Graph Neural Networks.

- [Xu+ ICLR 2019] How Powerful are Graph Neural Networks?

- [Sato+ NeurIPS 2019] Approximation Ratios of Graph Neural Networks for Combinatorial Problems.

- [Zhang+ ICLR 2024] Beyond Weisfeiler-Lehman: A Quantitative Framework for GNN Expressiveness.

- [Chen+ NeurIPS 2020] Can Graph Neural Networks Count Substructures?

- [Kanatsoulis+ ICLR 2024] Counting Graph Substructures with Graph Neural Networks.

- [Lanzinger+ ICLR 2024] On the Power of the Weisfeiler-Leman Test for Graph Motif Parameters.

- [Dong+ ICLR 2024] Rethinking the Power of Graph Canonization in Graph Representation Learning with Stability.

時系列データ(11 件)

GNN の講演をすると、「時系列データにも適用できますか?」と質問されることがよくあるのですが、できます。そういう質問がよく上がるということは、時系列データに GNN を適用したいという需要が高いということなのだと思います(同時に、私が講演で時系列データの紹介をサボっているということも表します)。

GNN を時系列データに適用することは非常に簡単にできてしまい技術的な課題が少ないので、基礎的な研究は少なく、応用研究が多い印象です。

ICLR 2024 では、脳波などの生体センサーデータ [Liu+ ICLR 2024, Song+ ICLR 2024] や電子カルテデータ [Poulain+ ICLR 2024] など医療応用の研究がいくつか見られました。

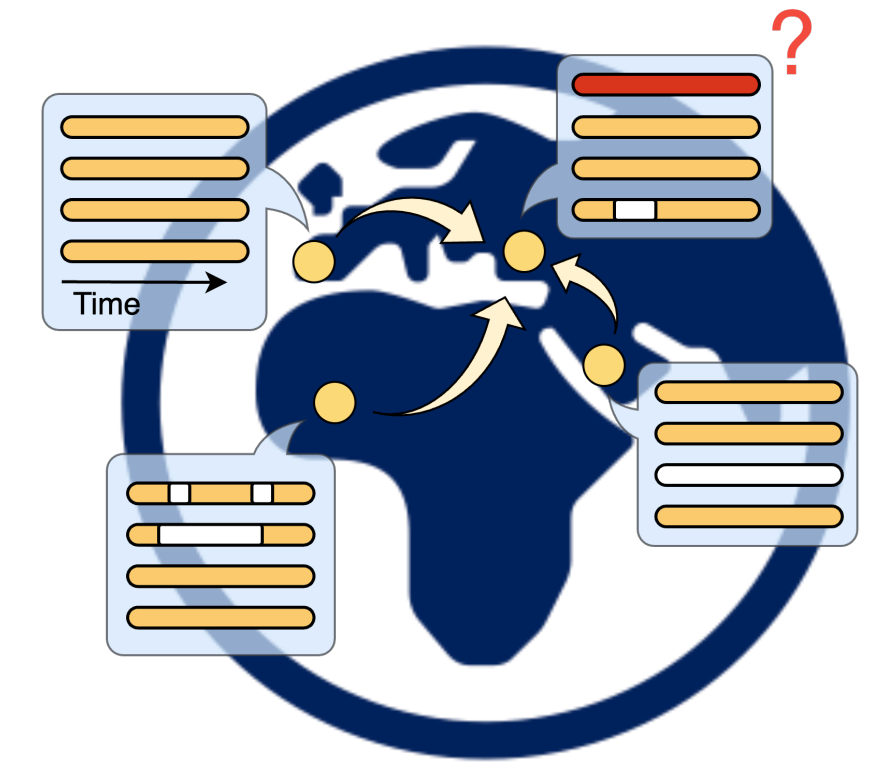

[De Felice+ ICLR 2024] では、センサーの欠損値を周囲のセンサーから推定する仮想センシングに GNN を応用しています(上図)。GNN + 時系列データの分かりやすくてよい応用例だと思います。

- [Liu+ ICLR 2024] VBH-GNN: Variational Bayesian Heterogeneous Graph Neural Networks for Cross-subject Emotion Recognition.

- [Song+ ICLR 2024] Decoding Natural Images from EEG for Object Recognition.

- [Poulain+ ICLR 2024] Graph Transformers on EHRs: Better Representation Improves Downstream Performance.

- [De Felice+ ICLR 2024] Graph-based Virtual Sensing from Sparse and Partial Multivariate Observations.

分子(10 件)

分子データは GNN の応用先の花形です。創薬や材料工学など、社会的にインパクトの大きい魅力的な応用がたくさん提案されています。

創薬にしろ材料工学にしろ、良い分子を見つけることが目標になることが多いので、生成モデルの研究が盛んです。

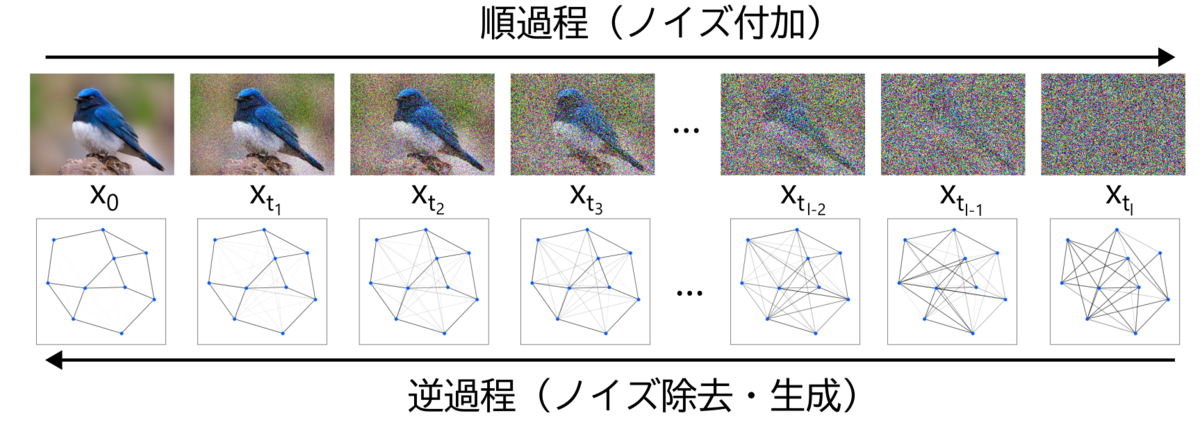

分子データは拡散モデルが最も勢いがある印象です。拡散モデル + GNN 自体は [Niu+ AISTATS 2020] で提案されてから既に 4 年以上経過していますが、ICLR 2024 でも [Le+ ICLR 2024, Huang+ ICLR 2024] など新しい拡散モデルが提案されました。拡散モデルをグラフデータに適用すること自体にはそこまで技術的な障壁は無いのですが、分子特有の対称性(同変性)を入れたり、三次元空間での原子の位置関係を考慮したり、応用に根ざした帰納バイアスを入れるところがこのトピック特有の課題としてよく研究されています。

ICLR 2024 においてこの分野における特筆すべき成果は [Beaini+ ICLR 2024] でしょう。1 億以上の分子からなる超巨大なデータセットを整備し、分子データのための基盤モデルの構築を試みています。MILA など複数のグループに渡る 35 名の研究者からなる大きなプロジェクトです。この論文はどちらかというとデータセットの整備が中心で、基盤モデルの構築はまだ道半ばといった感じです。複数タスクで訓練したモデルが他のタスクにうまく転移できている例もありますが、最大のデータセットではうまくいっていません。このあたりは今後の課題でしょう。ですが、グラフデータに対する生成モデルはテキストや画像などと比べてデータ不足のために遅れがちだった問題に対して大きく前進することはできました。この研究を足がかりに、モデルもスケールするなどして今後 1 ~ 2 年でこの分野は大きく進展するのではないかと思います。

- [Niu+ AISTATS 2020] Permutation Invariant Graph Generation via Score-Based Generative Modeling.

- [Le+ ICLR 2024] Navigating the Design Space of Equivariant Diffusion-Based Generative Models for De Novo 3D Molecule Generation.

- [Huang+ ICLR 2024] Protein-Ligand Interaction Prior for Binding-aware 3D Molecule Diffusion Models.

- [Beaini+ ICLR 2024] Towards Foundational Models for Molecular Learning on Large-Scale Multi-Task Datasets.

タンパク質(8 件)

タンパク質データについての動向も分子データとよく似ています。タンパク質でも RFDiffusion [Watson+ Nature 2023] など拡散モデルによる生成が人気です。タンパク質では三次元の折りたたみなど、構造がはっきりとあるので、そのあたりのドメイン知識を組み込んだモデルがよく研究されている印象です。ICLR 2024 では [Mao+ ICLR 2024] が代表例です。

- [Watson+ Nature 2023] De novo design of protein structure and function with RFdiffusion.

- [Mao+ ICLR 2024] De novo protein design using geometric vector field networks.

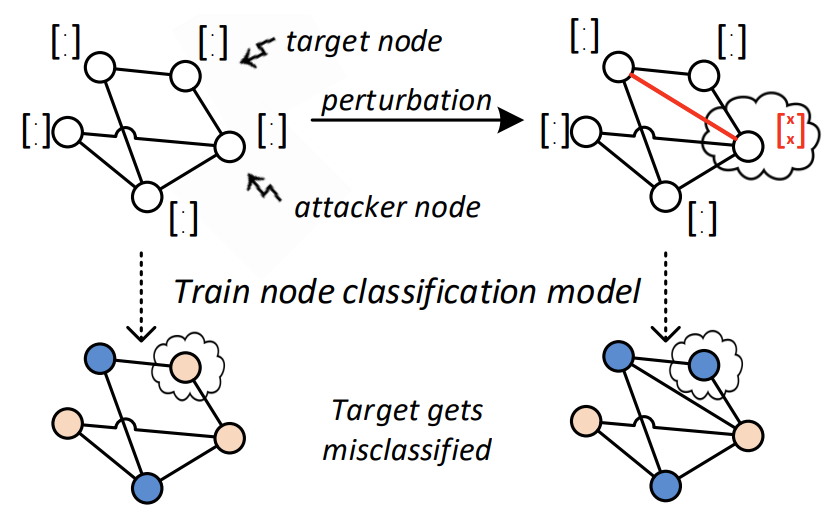

頑健性(8 件)

ベクトル用のニューラルネットワークでも敵対的攻撃や防御がよく研究されていますが、GNN でもよく研究されています。GNN に対する敵対的攻撃と防御は [Zügner+ KDD 2018, Zügner+ KDD 2019] あたりが最初なのでかれこれ 6 年くらい研究されています。ベクトル用のニューラルネットワークでは、攻撃と防御についての基本的なアプローチは出尽くして、完全に敵対的攻撃が防げるわけではないが落とし穴もだいたい知られて敵対的攻撃と共生していく成熟した段階という印象ですが、GNN でも状況は同様です。違いがあるとすれば、ニューラルネットワークは大規模にスケールさせると OOD への汎化性能が上がり敵対的攻撃への防御力が自然に向上したのに対して、GNN ではモデル自体をスケールさせることがあまりなく、人手で頑張って対応する必要性がより大きいところかと思います。

最も簡単な防御法は、データを摂動させてからモデルに入力することを繰り返し、多数決で最終的な予測を出すことで、攻撃をぼかしてしまうというものです。ICLR 2024 では GNNCert [Xia+ ICLR 2024] や DRAGON [Yuan+ ICLR 2024] がこの系統に属します。また、データを生成モデルなどで明示的に正常データに変換してから GNN に入力することで防御する方法もあります。DRAGON [Yuan+ ICLR 2024] はこの種の防御法も用います。

GNN はベクトル用のニューラルネットワークを含むので GNN の防御は通常より一段難しい問題であり、当面の間は他のニューラルネットワークと同じように、攻撃と防御でいたちごっこをしながら漸進しつつ、緩やかな共生の道に進むのではないかと思います。

- [Zügner+ KDD 2018] Adversarial Attacks on Neural Networks for Graph Data.

- [Zügner+ KDD 2019] Certifiable Robustness and Robust Training for Graph Convolutional Networks.

- [Xia+ ICLR 2024] GNNCert: Deterministic Certification of Graph Neural Networks against Adversarial Perturbations.

- [Yuan+ ICLR 2024] Mitigating Emergent Robustness Degradation while Scaling Graph Learning.

高速化関連(6 件)

FastGCN [Chen+ ICLR 2018] のような GNN そのものの高速化は既に成熟しているためあまりなく、特殊なケースを高速化したり、他のタスクの高速化に GNN を使ったりというような研究が目立ちました。

例えば、[Liu+ ICLR 2024] では、暗黙的 GNN という、全ての層の重みを共有した無限層の GNN をミニバッチで高速に訓練する手法を提案しています。[Park+ ICLR 2024] では、forward-forward アルゴリズム [Hinton 2022] のような逆伝播を使わず順伝播のみで GNN を訓練する手法を提案しています。ベクトル用のニューラルネットワークについて提案されたアイデアを GNN に拡張するというのは定番の流れですね。

- [Chen+ ICLR 2018] FastGCN: Fast Learning with Graph Convolutional Networks via Importance Sampling.

- [Liu+ ICLR 2024] Scalable and Effective Implicit Graph Neural Networks on Large Graphs.

- [Park+ ICLR 2024] Forward Learning of Graph Neural Networks.

- [Hinton 2022] The Forward-Forward Algorithm: Some Preliminary Investigations.

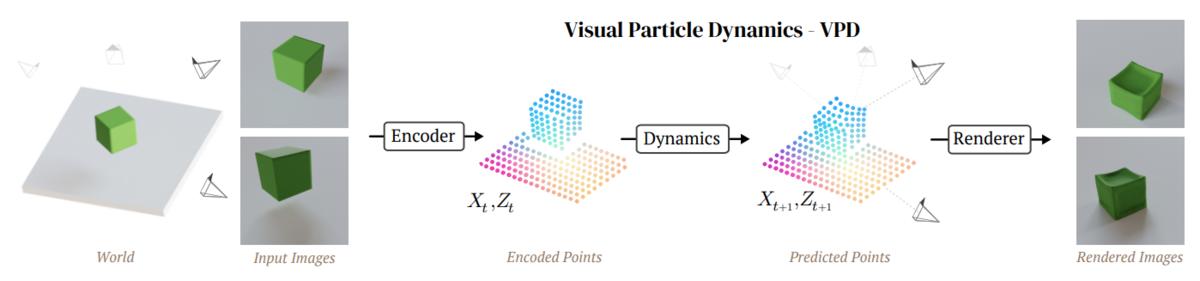

物理(6 件)

GNN を物理シミュレーションへ応用させることも最近人気です。一つのきっかけは ICLR 2021 で傑出論文賞 (outstanding paper award) を受賞した [Pfaff+ ICLR 2021] だと思います。こちらの研究は僕たちがグラフニューラルネットワークを学ぶ理由 - Speaker Deckでも紹介しました。GNN を使ってかなり高精度に物理シミュレーションを実現しています(下動画)。

ICLR 2024 でも物理シミュレーション応用が目立ちました。中でも、各粒子にセンサーがなくても (RGBD) 動画観測から粒子シミュレーターを学習できる [Whitney+ ICLR 2024] や、部分的な観測だけからシミュレーターを学習する [Janny+ ICLR 2024]、メタ学習を基に未知の物理システムに汎化できる [Song+ ICLR 2024] など、データ駆動特有の利点を活かした研究が多く見られました。

- [Pfaff+ ICLR 2021] Learning Mesh-Based Simulation with Graph Networks.

- [Whitney+ ICLR 2024] Learning 3D Particle-based Simulators from RGB-D Videos.

- [Janny+ ICLR 2024] Space and time continuous physics simulation from partial observations.

- [Song+ ICLR 2024] Towards Cross Domain Generalization of Hamiltonian Representation via Meta Learning.

おわりに

気付いたら気合の入った記事になっていました。2024 年 5 月時点の GNN 研究のスナップショットとして良い記録になったのではないかと思います。

GNN 自体のコア技術はかなり成熟した一方で、様々な分野に応用が広がったために現実的な問題がたくさん出てきて、それらの解決を目指している段階であるというような感触を持っています。応用分野が広がった分、論文の数も非常に増えています。

拙著『グラフニューラルネットワーク』を読み終えた方は、これらの論文の多くはスムーズに読み進められるようになっているはずです。気になった研究があればぜひ原典にあたっていただければと思います。

本稿でグラフニューラルネットワークに興味を持った方は、拙著『グラフニューラルネットワーク』を読んでいただければ嬉しく思います。読んで損はさせません。よろしくお願いいたします。

連絡先: @joisino_ / https://joisino.net